介護や福祉の分野でも、ロボットやAIをはじめ、xR(クロスリアリティ)やセンサーなどの最先端技術が積極的に導入・活用されるようになってきた。とはいえ、こうした分野では特に人間同士のコミュニケーションが重視されるので、最先端技術も単に省力化や合理化を目的に導入・活用されるわけではない。認知症患者への介護手法として近年注目されている介護技法・ユマニチュードにおいても、その人材育成のための訓練にさまざまな最先端技術が使われようとしている。

ARで優しい介護の提供を訓練

ユマニチュードとは、認知症患者への「優しい介護」として注目されている、フランスで提唱された介護技法だ。認知症患者を介護する際に、一番重要なのはコミュニケーションだという。患者とのコミュニケーションが取れていないと、相手が急に非協力的になりがちで、介護の提供が難しくなる。そこで、スムーズに介護ケアを行うための手法として考え出された。

ユマニチュードは、「見る」「話す」「触れる」「立たせる」の4つのスキルからなる複合的な技術で、それらを同時に適切なタイミングで実施することで認知症患者とのコミュニケーションを図る。その上で、人と人とのつながりを意識しながらケアを提供する手法だが、これらのことを同時に行うのは簡単ではない。この中で、通常の介護では「立たせる」以外の3つ、「相手の目を見つめて、体に触れながら話しかけること」が必要になる。

こうした手法が理想的だとわかっていても、ユマニチュードは感覚に大きく依存する技能であるため、教えるのも修得するのも難しい。一方、介護現場ではユマニチュードの導入によるBPSD (認知症行動・心理症状)の減少やバーンアウト(燃え尽き症候群)の防止などの効果が報告されているが、複数のスキルをケアの状態に応じて適切に組み合わせる必要があるため、習得には専門的な訓練が必要になる。

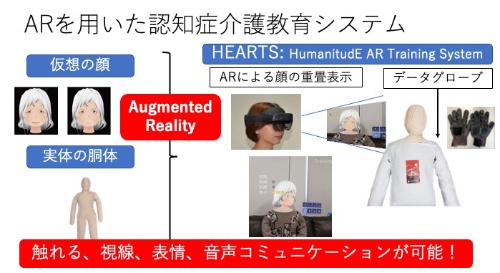

通常、訓練では健常者が模擬患者を演じたり、患者の代わりに人形を使ったりするが、模擬患者には認知症患者としてのスキルが必要であり、人形ではユマニチュードで重要なコミュニケーションが訓練しづらい。そこで、九州大学 システム情報科学研究院 教授の倉爪亮氏(写真1)が開発したのが、人形の頭部にAR(拡張現実)の技術を活用して仮想患者の顔(アバター)を貼り付け、人形の体への触れ方や強さなどを触覚センサーグローブで計測してAIで解析しスコア化する、認知症介護教育システム「HEARTS」(図1)だ。

「見る」「触れる」「話す」をシステムが評価

HEARTSでは、訓練者はマイクロソフトの「HoloLens 2」のARゴーグルをかけ、センサーグローブを付けた手で人形に触れる(写真2)。ユマニチュードで重要な、患者と目線を合わせる「見る」スキルは、ゴーグルで読み取った訓練者とアバターの視線方向の一致度で判定し、「触れる」スキルはセンサーグローブで強さを計測する。さらに、「話す」スキルの計測にはHoloLens 2の マイクロフォンを用い、音圧が一定値以上であれば話しているとみなされる。

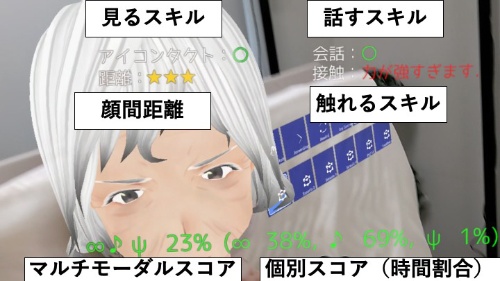

仮想患者のアバターはランダムに顔の方向を変えるので、まず訓練者はアバターの顔の正面に自分の体を動かして、アバターの視線を捉える。その後、訓練者は目を合わせたまま20cmまで顔を近づけていき、声をかけ続けながら人形の体に触れる。この時、「見る」「触れる」「話す」が実施できている個々の時間や、少なくとも2つ以上組み合わせて実施できている時間が記録されると同時に、ゴーグル内やパソコンの画面上にも表示される(図2)。

さらに、目線が合った時や強く触りすぎた時などに画面にメッセージが表示されるとともに、アバターの表情が変化し、「ウフフ」や「ウッ」などの音声で反応を返す機能が実装されている(動画)。「見る」「触れる」「話す」が全く出来ていない時には、音声で「コミュニケーションがありません」と警告が出る。

体に触れる際には強さだけでなく、親指を使わずにできるだけ手のひらを使って、つかまずに広い面積に触れているのかも計測される。また、指先から体に触れ手のひらから離すのがいい触れ方で、それができているかどうかもグローブの圧力分布からAIを使って計測させる。そして、介護の基本動作を行う際に大切な「見ながら・話しながら・触れる」というコミュニケーションの同時性についても、HEARTSを使って訓練ができる。

ただし、「話す」に関しては、まだ内容までは判定できない。「本当は介護する人が発する言葉も、AIで解析してポジティブな言葉かどうかを判定したい。さらに、感情があるかどうかを判定できる技術も、近いうちに実装できそうだ」(倉爪氏)。